Contente

Q:

Por que as redes neurais artificiais recorrentes geralmente são difíceis de treinar?

UMA:

A dificuldade de treinar redes neurais artificiais recorrentes tem a ver com sua complexidade.

Uma das maneiras mais simples de explicar por que as redes neurais recorrentes são difíceis de treinar é que elas não são redes neurais avançadas.

Nas redes neurais avançadas, os sinais se movem apenas em uma direção. O sinal se move de uma camada de entrada para várias camadas ocultas, e para frente, para a camada de saída de um sistema.

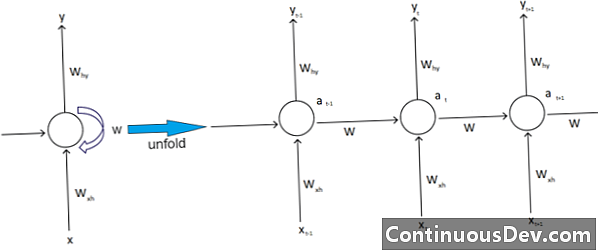

Por outro lado, redes neurais recorrentes e outros tipos diferentes de redes neurais têm movimentos de sinal mais complexos. Classificadas como redes de "feedback", as redes neurais recorrentes podem ter sinais viajando para frente e para trás e podem conter vários "loops" na rede em que números ou valores são retornados à rede. Os especialistas associam isso ao aspecto das redes neurais recorrentes associadas à sua memória.

Além disso, há outro tipo de complexidade que afeta as redes neurais recorrentes. Um excelente exemplo disso é no campo do processamento de linguagem natural.

No sofisticado processamento de linguagem natural, a rede neural precisa ser capaz de lembrar as coisas. Ele também precisa receber insumos. Suponha que exista um programa que queira analisar ou prever uma palavra em uma frase de outras palavras. Pode haver, por exemplo, um comprimento fixo de cinco palavras para o sistema avaliar. Isso significa que a rede neural precisa ter entradas para cada uma dessas palavras, juntamente com a capacidade de "lembrar" ou treinar o golpe dessas palavras. Por essas e outras razões semelhantes, as redes neurais recorrentes normalmente têm esses pequenos loops e feedbacks ocultos no sistema.

Especialistas lamentam que essas complicações dificultem o treinamento das redes. Uma das maneiras mais comuns de explicar isso é citando o problema de gradiente de explosão e desaparecimento. Essencialmente, os pesos da rede levarão a valores de explosão ou desaparecimento com um grande número de passes.

O pioneiro da rede neural Geoff Hinton explica esse fenômeno na web, dizendo que passes lineares inversos farão com que pesos menores encolham exponencialmente e pesos maiores que explodam.

Esse problema, ele continua, piora com longas sequências e etapas de tempo mais numerosas, nas quais os sinais crescem ou decaem. A inicialização do peso pode ajudar, mas esses desafios estão embutidos no modelo de rede neural recorrente. Sempre haverá esse problema associado ao seu design e construção específicos. Essencialmente, alguns dos tipos mais complexos de redes neurais realmente desafiam nossa capacidade de gerenciá-las facilmente. Podemos criar uma quantidade praticamente infinita de complexidade, mas geralmente vemos os desafios de previsibilidade e escalabilidade crescerem.